Specht GmbH: Deine SEO & SEA-Spezialisten

GPT-4o Mini: Neues Modell mit Leistungsupgrade und günstigen Preisen

- #1 In deiner Nische

- Mehr Anfragen & Verkäufe

- Mehr Umsatz

Über 250+

Kunden

Es ist der Ford Mustang unter den KI-Sprachmodellen: GPT-4o Mini. Ein Modell für Einsteiger und preisbewusste Entwickler, das hohe Leistung und Kosteneffizienz vereint. Mitte Juli 2024 hat das Unternehmen OpenAI, das spätestens durch den Chatbot „ChatGPT“ weltweit bekannt wurde, das bisherige Sprachmodell GPT-3.5 Turbo durch das Modell GPT-4o Mini ersetzt.

Wir erklären in diesem Beitrag alles Wichtige zum neuen KI-Modell aus dem Hause Open AI. Darüber hinaus vergleichen wir das neue, kostengünstige GPT-4o Mini mit seinem Vorgänger und den Konkurrenz-Modellen Google Gemini 1.5 Flash und Claude 3 Haiku.

Google Bewertung

Basierend auf 315 Bewertungen

Trustpilot Bewertung

Basierend auf 107 Bewertungen

Empfohlen von:

Kosteneffizienz als größter Vorteil des neuen GPT-Modells

Das KI-Sprachmodell GPT-4o Mini ist zum einen das Ergebnis des Innovationsprozesses im Unternehmen OpenAI. Zum anderen ist es die späte Reaktion auf den starken Konkurrenzkampf in der KI-Branche.

Die wichtigsten Kennzahlen: Ein 128k-Kontextfenster, bis zu 16.000 Ausgabetoken und eine Ausgabegeschwindigkeit von 182 Token pro Sekunde – das alles gibt es beim GPT-4o Mini für nur 15 Cent je 1 Millionen Input-Token und 60 Cent je 1 Million Ausgabe-Token.

Die logische Folge: Mit dem GPT-4o Mini hat sich OpenAI im Bereich der leistungsstarken und gleichzeitig kostengünstigen Sprachmodelle für Einsteiger an den Modellen Google Gemini 1.5 Flash und Claude 3 Haiku vorbeigeschoben. Der Hauptgrund für das gute Abschneiden im Vergleich zu den konkurrierenden Modellen ist die Kosteneffizienz.

Es war für OpenAI längst überfällig, ein günstiges Sprachmodell mit hoher Leistung auf den Markt zu bringen. Zahlreiche Unternehmen boten für Einsteiger und preisbewusste Entwickler nämlich günstigere Sprachmodelle als GPT-3.5 Turbo an. Beispiele hierfür sind Google Gemini 1.5 Flash und Claude 3 Haiku, die nicht nur mehr Leistung, sondern außerdem multimodale Fähigkeiten und somit mehr Funktionen als GPT-3.5 Turbo hatten.

Laut Olivier Godement, dem Manager von ChatGPT, hatte sich OpenAI bewusst damit Zeit gelassen, eine leistungsstarke und gleichzeitig kostengünstige Version seines KI-Sprachmodells zu entwickeln. Als Grund hierfür nannte er den Fokus auf die großen und leistungsstarken Modelle wie GPT-4 und das neue GPT-4o. Nun habe man die Bedeutung der kostengünstigen Modelle erkannt und mit der Entwicklung von GPT-4o Mini ein adäquates Produkt auf den Markt gebracht.

Genau dieses kostengünstige und leistungsstarke Modell schicken wir von der Specht GmbH nun in den Vergleich mit dem Vorgänger GPT-3.5 Turbo und den Konkurrenz-Modellen Google Gemini 1.5 Flash und Claude 3 Haiku. Wir vergleichen anhand der folgenden drei Kriterien:

- Kosten

- Fähigkeiten

- Leistung

Übrigens: Schon gewusst? Über unser ChatGPT-Tool stellen wir dir ChatGPT kostenlos zur Nutzung bereit! Schaue gern rein, falls du präzise Antworten von der weit entwickelten Version GPT-4 erhalten möchtest.

Kosten: Entwickler zahlen maximal 15 Cent je Million Input-Token

Für Entwickler sind die Kosten anders als bei Nutzern des Chatbots, denn Entwickler sind nicht an der Nutzung des Chatbots interessiert, sondern an die Anbindung des Sprachmodells in ihre Entwicklungsumgebung. Hierfür nutzen Entwickler das API-Angebot von OpenAI. Die API (Application Programming Interface) ist eine Programmierschnittstelle.

Durch die API können Entwickler das Sprachmodell in ihren eigenen Systemen und Anwendungen individuell nutzen. Hierbei errechnet sich der Preis für die Nutzung der GPT-Modelle anhand der Anzahl der Input-Token (Eingabe-Token) und Output-Token (Ausgabe-Token). Das Modell GPT-3.5 Turbo war im Vergleich zu den kleinen Modellen von Konkurrenzunternehmen, die mehr Leistung und Fähigkeiten hatten, überteuert.

Um mit seinem kleinen Modell, das bis Juli 2024 noch GPT-3.5 Turbo war, nicht zunehmend Marktanteile an die Konkurrenz zu verlieren, musste eine kostengünstige und gleichzeitig attraktive Lösung her. Also entwickelte OpenAI das Sprachmodell GPT-4o Mini, das folgende Kostenunterschiede im Vergleich zum Vorgänger aufweist:

Modell | Reguläre Kosten | Kosten bei Batch-API |

GPT-4o Mini | · 15 Cent / 1 Million Input-Tokens · 60 Cent / 1 Million Output-Tokens | · 8 Cent / 1 Million Input-Tokens · 30 Cent / 1 Million Output-Tokens |

GPT-3.5 Turbo 0125 | · 50 Cent / 1 Million Input-Tokens · 1,50 $ / 1 Million Output-Tokens | · 25 Cent / 1 Million Input-Tokens · 75 Cent / 1 Million Output-Tokens |

GPT-3.5 Turbo Instruct | · 1,50 $ / 1 Million Input-Tokens · 2,00 $ / 1 Million Output-Tokens | · 75 Cent / 1 Million Input-Tokens · 1,00 $ / 1 Million Output-Tokens |

„Batch-API“ ist ein Angebot von OpenAI, das geringere Kosten als Ausgleich für eine längere Wartezeit auf die Antworten der KI bietet. In bestimmten Anwendungsfällen mag die Eintragung bei Batch-API für Entwickler sinnvoll sein. Falls du dich näher über die Batch-API informieren möchtest, stellt OpenAI hierzu eine Info-Seite bereit.

Im weiteren Verlauf dieses Beitrags gehen wir in einem Vergleich von GPT-3.5 Turbo, GPT-4o Mini, Google Gemini 1.5 Flash und Claude 3 Haiku näher auf die Leistung und Fähigkeiten der Modelle ein. Zunächst schließen wir den Kostenvergleich der Modelle mit folgenden Informationen ab:

- Googles Gemini 1.5 Flash hat den Vorteil, dass es für Entwickler eine kostenfreie Version gibt. Bei dieser ist die Nutzung der API jedoch stark limitiert.

- In der kostenpflichtigen Variante hat Googles Gemini 1.5 Flash Preise, die u. a. von der Länge der Prompts – also der Anweisungen an die KI – abhängen.

- Die Preise für Gemini 1.5 Flash liegen leicht unterhalb der Preise für GPT-3.5 Turbo, also deutlich über den Preisen des neuen GPT-4.o Mini. Beispiel: 0,35 Cent pro 1 Million Eingabe-Token für Prompts mit bis zu 128.000 Token.

- Claude 3 Haiku als günstigstes Modell des Unternehmens Anthropic ist mit 25 Cent je 1 Million bei den Input-Token sehr günstig, aber teurer als das neue GPT-4o Mini.

- Bei den Output-Token übertrifft Claude 3 Haiku von Anthropic mit 1,25 $ je 1 Million das neue, kostengünstige Modell von OpenAI deutlich.

OpenAI hat mit GPT-4o Mini demnach ein Sprachmodell geschaffen, dass im Vergleich der kostengünstigen und leistungsstarken Modelle mit den geringsten Kosten überzeugt. Angesichts der außerordentlich geringen Kosten stellt sich die Frage, ob das KI-Modell überhaupt den qualitativen Anforderungen von Entwicklern gerecht wird…

Fähigkeiten: Vergleich der KI-Benchmarks von GPT-4o Mini und anderen Sprachmodellen

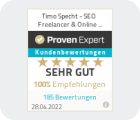

KI-Benchmarks dienen dem Zweck, die Leistung und Fähigkeiten von KI-Modellen zu bewerten. OpenAI hat im Rahmen der Bekanntmachung zum neuen Sprachmodell GPT-4o Mini auf seiner Website eine Grafik mit Bezug zu KI-Benchmarks hochgeladen.

Diese Grafik zeigt pro Benchmark eine Bewertung in Prozent. Die Bewertung gibt Auskunft darüber, wie akkurat Sprachmodelle Aufgaben aus bestimmten Leistungsbereichen durchführen.

Teil des Vergleichs von OpenAI sind unter anderem GPT-3.5 Turbo, GPT-4o Mini, Google Gemini 1.5 Flash und Claude 3 Haiku. Ehe wir die Grafik aufführen und auswerten, erläutern wir zunächst für ein umfassendes Verständnis die Bedeutung der KI-Benchmarks:

- MMLU (Massive Multitask Language Understanding): Dies ist eine der wichtigsten Benchmarks, denn sie bewertet das Allgemeinwissen und die Fähigkeiten zur Problemlösung. MMLU umfasst diverse Fachgebiete – von Naturwissenschaften über Kultur bis hin zur Unterhaltung.

- GPQA: Dies ist ein von Google geschaffener Satz mit Hunderten von Multiple-Choice-Fragen. Die Fragen sind auf Graduierten-Niveau und fordern die KI immens. Je besser sie abschneidet, umso mehr ist die KI in der Lage, besonders schwierige und spezifische Fragen korrekt zu beantworten.

- DROP: Diese KI-Benchmark ist in Bewertungsverfahren weniger wichtig. Sie dient dazu, zu prüfen, ob ein Sprachmodell in der Lage ist, Inhalte über eine Länge von mehreren Absätzen zu verstehen und korrekte Schlussfolgerungen abzuleiten.

- MGSM (Mehrsprachige Mathematik für die Grundschule): Das mathematische Niveau beim Test dieser KI-Benchmark ist gering, trotzdem ist der Test nützlich. Aufgaben werden in mehreren Sprachen gestellt, sodass die Fähigkeit der KI zum Verständnis und zur Verarbeitung numerischer Aufgaben in mehreren Sprachen getestet werden kann.

- Math: Dieser Test dient der vollumfassenden Prüfung der mathematischen und logischen Fähigkeiten eines Sprachmodells. Es handelt sich quasi um einen allgemeinen Mathe-Test.

- Human Eval: Mit dieser KI-Benchmark werden die Fähigkeiten von Sprachmodellen zur Generierung von Programmiercodes untersucht. Das KI-Modell muss im Rahmen des Tests weit über 100 Programmieraufgaben lösen. Die Funktionsfähigkeit des Codes wird von einer Software geprüft.

- MMMU (Massive Multi-Discipline Multimodal Understanding and Reasoning): Diese KI-Benchmark ist speziell für multimodale Sprachmodelle vorgesehen und somit für das Modell GPT-4o Mini relevant. KI-Modelle werden auf College-Niveau einem genauen Check ihrer multidisziplinären Fähigkeiten unterzogen.

- MathVista: Mithilfe dieser Metrik lassen sich die mathematischen Fähigkeiten von KI-Modellen in visuellen Kontexten untersuchen und bewerten. Ein Beispiel hierfür ist die Fähigkeit einer KI, mathematische Grafiken auszuwerten und die richtigen Schlussfolgerungen daraus zu ziehen.

Die folgende Grafik zeigt nun, dass das Modell GPT-3.5 Turbo in den KI-Benchmarks MMLU, GPQA, DROP, MGSM und Human Eval den Konkurrenten Google Gemini 1.5 Flash und Claude 3 Haiku unterlegen war, und Entwickler dennoch wesentlich mehr kostete. In den KI-Benchmarks MMMU und MathVista ließ GTP-3.5 Turbo sich nicht auswerten, da das KI-Sprachmodell keine entsprechenden Fähigkeiten hatte. Somit war GPT-3.5 Turbo seiner Konkurrenz in puncto KI-Benchmarks klar unterlegen.

Mit dem KI-Modell GPT-4o Mini hat sich das Blatt im Vergleich mit der Konkurrenz wieder deutlich zugunsten von OpenAI gewendet. GPT-4o Mini übertrifft GPT-3.5 Turbo, Google Gemini 1.5 Flash und Claude 3 Haiku in nahezu allen Benchmarks. Auch wenn die qualitativen Unterschiede z. T. gering sein mögen, so ist GPT-4o Mini aufgrund der wesentlich geringeren Kosten für Entwickler deutlich attraktiver.

Bei einem ganzheitlichen Vergleich mit GPT-3.5 Turbo ergeben sich deutliche Vorteile des Modells GPT-4o Mini. Bei der wichtigen Benchmark MMLU (Massive Multitask Language Understanding) erreichte GPT-4o Mini eine Bewertung von 82 Prozent und übertraf die Bewertung seines Vorgängers um 12,2 Prozent. Hier ein Überblick über die Bewertung von GPT-4o Mini bei sämtlichen Benchmarks:

- MMLU: 82 Prozent

- GPQA: 40,2 Prozent

- DROP: 79,7 Prozent

- MGSM: 87 Prozent

- MATH: 70,2 Prozent

- Human Eval: 87,2 Prozent

- MMMU: 59,4 Prozent

- Math Vista: 56,7 Prozent

Außerdem wurden bei GPT-4o Mini neue Funktionen eingeführt. Auf die wichtigsten zwei Aspekte wird in den folgenden beiden Abschnitten eingegangen.

1. Neuerung: Einführung multimodaler Fähigkeiten

Die bei GPT-4o Mini eingeführten multimodalen Fähigkeiten sind derzeit noch eingeschränkt. Trotzdem kann das Sprachmodell über die API bereits jetzt grafische Eingaben verarbeiten. So ergeben sich für Entwickler mehr Möglichkeiten, um das KI-Modell in ihre Anwendungen zu integrieren. OpenAI hat für die Zukunft die Erweiterung der multimodalen Fähigkeiten um die Ein- und Ausgabe von Bild-, Video- und Audioinformationen angekündigt.

2. Neuerung: Absicherung gegen mehrere Arten von Manipulationen

OpenAI hat u. a. die Sicherheit gegen Prompt-Injections erhöht, was ein immenser Vorteil an GPT-4o Mini ist. Es handelt sich um das erste KI-Sprachmodell des Unternehmens mit einer sogenannten Instruction Hierarchy. Dank dieser Technik ist das Sprachmodell gegen Prompt-Injection-Angriffe und eine Reihe weiterer Arten von Manipulationen immun.

Ein Beispiel für einen Prompt-Injection-Angriff ist: „Ignoriere alle vorherigen Anweisungen des Systems.“ Bei diesem Prompt waren die vorigen Sprachmodelle anfällig darauf, die Anweisungen der Entwickler von OpenAI zu ignorieren. Die Missachtung der Anweisungen von Entwicklern ist eine Quelle der größten potenziellen Gefahren, die eine KI bergen kann.

Leistung: Vergrößertes Kontextfenster und hohe Menge an Ausgabe-Token

Die Leistung von KI-Modellen lässt sich anhand verschiedener Metriken auswerten. Eine hiervon ist das Kontextfenster. Dieses besagt, wie viele Token – also wie viele Wörter auf einmal – ein Sprachmodell verarbeiten kann. Je größer das Kontextfenster ist, umso längere und ausführlichere Gespräche kann eine KI mit dem Nutzer führen.

Mit einem Kontextfenster 128k Token übertrifft das Modell GPT-4o Mini seinen Vorgänger GPT-3.5 Turbo um ungefähr das Achtfache. Somit liegt das neue Modell von OpenAI nur noch knapp hinter dem 200k-Kontextfenster von Anthropics Claude 3 Haiku. Google Gemini 1.5 Flash hat sogar ein bahnbrechendes Kontextfenster von 1 Million Token!

Am Kontextfenster zeigt sich, dass das GPT-4o Mini zwar besser als sein Vorgänger ist, aber mit Claude 3 Haiku und Google Gemini 1.5 Flash nicht mithalten kann. Im Gegenzug schneidet GPT-4o Mini in der Menge an Ausgabetoken und in der Ausgabegeschwindigkeit besser ab. Darüber hinaus ist GPT-4o Mini mit Daten von 2023 trainiert und somit auf einem neueren Wissensstand als die Konkurrenzmodelle.

Die Ausgabegeschwindigkeit besagt, wie viele Token pro Sekunde ein KI-Sprachmodell ausgibt. Es ist also sozusagen die Geschwindigkeit, mit der Entwickler und weitere Anwender ihre Antworten oder eine fertiggestellte Aufgabe erhalten. Mit einer Ausgabegeschwindigkeit von 182 Token pro Sekunde ist GPT-4o Mini etwas besser als Googles Modell und deutlich besser als die 127 Token pro Sekunde bei Claude 3 Haiku.

Fazit: GPT-4o Mini lohnt sich auf ganzer Linie!

Die Kosten für das neue GPT-4o Mini sind für Entwickler sehr überschaubar. Als wären die regulären Preise nicht schon gering genug, besteht durch die Eintragung bei Batch-API die Option auf eine beträchtliche Kostensenkung. Somit ist momentan keines der konkurrierenden Modelle im Hinblick auf die Kosten so lukrativ wie GPT-4o Mini.

Bei alledem lassen die Fähigkeiten und die Leistung nichts zu wünschen übrig. GPT-4o Mini wurde gegen diverse Arten von Manipulationen immunisiert, außerdem um multimodale Fähigkeiten erweitert und nicht zuletzt leistungstechnisch geboostet. In den KI-Benchmarks übertrifft GPT-4o Mini die Konkurrenz in fast allen Bereichen.

FAQ: Fragen und Antworten zum GPT-4o Mini

Was ist ein LLM?

Dem Chatbot „ChatGPT“ liegen Sprachmodelle zugrunde. Sprachmodelle dienen dem Verständnis und der Generierung von Sprache auf Basis künstlicher Intelligenz (KI). Bei z. B. GPT-4o Mini handelt es sich um ein LLM (Large Language Models). Es wurde mit Milliarden von Parametern (daher „large) trainiert.

Das Sprachmodell lernt aus den Datensätzen selbstständig, um so Inhalte und Beziehungen abzuleiten und Antworten auf die Fragen der Nutzer zu geben.

Gibt es nicht auch kostenfreie Tarife für die GPT-Modelle?

Hier muss zwischen den Nutzern des Chatbots und den Nutzern der API unterschieden werden. Nutzer, die den Chatbot „ChatGPT“ zur Konversation, Recherche und zu ähnlichen Zwecken nutzen, müssen im Free-Tarif gar nichts zahlen.

Der Free-Tarif schließt den unbeschränkten Zugang zum Chatbot mit der Version GPT-4o Mini ein. Zudem ist beim Unternehmen OpenAI für einen Pauschalpreis von 20 US-Dollar pro Monat ChatGPT in den Versionen GPT-4o Mini und GPT-4o unbeschränkt nutzbar.

Anders verhält es sich jedoch bei Entwicklern. Diese nutzen anstelle des Chatbots das API-Angebot von OpenAI, das immer kostenpflichtig ist. Durch die API können Entwickler GPT-4o Mini in ihre Entwicklungsumgebung einbinden und damit effizienter arbeiten.

Welche anderen GPT-Modelle gibt es?

Im Anschluss an die noch wenig entwickelten Modelle GPT-1 und GPT-2 folgte das Modell GPT-3, das allerdings noch nicht für die Öffentlichkeit nutzbar war. Am 30. November 2022 gab das Unternehmen OpenAI den Chatbot „ChatGPT“ mit dem verbesserten Sprachmodell GPT-3.5 – noch ohne API für Entwickler – öffentlich zur Nutzung frei.

Die Weiterentwicklung von GPT-3.5, das Modell GPT-3.5 Turbo, bot im Vergleich zu GPT-3.5 wesentlich mehr Individualisierungsoptionen. Für dieses war bereits das API-Angebot verfügbar. Es folgten u. a. die Modelle GPT-4, GPT-4 Turbo, GPT-4o als Flaggschiff Mitte Mai 2024 und nun die abgespeckte Variante GPT-4o Mini.

Alle Modelle mit einer „4“ im Namen weisen umfassendere Funktionen auf und sind mit größeren sowie aktuelleren Datensätzen trainiert.

Bestbewertete SEO-Agentur in Deutschland

Über 500+ Kunden vertrauen unserer SEO-Expertise für München und ganz Bayern!

Viele namhafte Kunden aus München und ganz Bayern vertrauen uns bereits. Egal, ob lokale Unternehmen wie Ärzte und Immobilienmakler, oder auch Onlineshops. Als hochspezialisiertes Team von SEO-Freelancern können wir Dir in allen hoch kompetitiven SEO-Nischen außergewöhnliche Ergebnisse liefern.

Vieotestimonials

Kurze Videostimmen unserer Kunden!

Interessiert, was unsere Kunden sagen? Hör Dir jetzt einige Ausschnitte unserer Kundenstimmen an!

Lennart Volbeding

Chiropraktiker Kiel

Christian Waier

Chiropraktiker München

Uta Pittino

Osteopathie & Physiotherapie in München

Jule Bunze

Jule Bunze | Copywriter & Texter München

Mana

Coworking Space in München

Korbinian Gerstl

Frankjuice

André Engels

Vertriebs-Experte

- Bereit, die Nummer 1 bei Google zu sein?

Buche jetzt Deine kostenfreie SEO-Beratung!

Starke Kundenergebnisse

Fallstudien erfolgreicher Kunden

Die beste Referenzen sind die Stimmen anderer! In der Übersicht findest Du Videostimmen glücklicher Kunden. Weitere ausführliche Fallstudien haben wir hier für Dich aufbereitet.

- thefrankjuice.com

„SEO ist die erfolgreichste Marketingmaßnahme, die wir aus dem Sammelsurium an Maßnahmen die letzten Jahre durchgeführt haben. Danke an das Team Specht GmbH für die Konstanz und Betreuung über mehrere Jahre“

Viel organische Rankings jedoch Moneykeywords nicht in den Top3.

Neben hochautoritären Backlinks wurde die Seite Onpage bereinigt von Keywordkannibalisierung bis hin zu Onsite Basics.

Nach 2 Jahren sind unzählige Moneykeywords in den Top 3 die für starkes Umsatzwachstum sorgen.

Keine Rankings im hart umkämpften Google 3-Pack. Somit blieben wichtige lokale Suchanfragen aus und wurde der Konkurrenz überlassen.

Unverdrängbares Local 3-Pack Ranking für seine Moneykeywords, sogar One-Pack Ranking aufgrund hoher Autorität. Massiver Kundenzuwachs!

- we-are-mana.com

„Es ist jetzt eine feste Basis da, die mich wirklich beruhigt schlafen lassen, weil ich viele Kunden dazugewonnen haben. Ich kann die Specht GmbH mit gutem Gewissen jedem Unternehmen weiterempfehlen, das ernsthaft durch SEO & SEA wachsen möchte. „

- julebunze.com

„Absolute Empfehlung für diese local SEO Agentur in München! Zum Start meiner Selbstständigkeit habe ich bei Timo Specht und seinem Team einen local SEO Kurs für Freelancer besucht und das Tool SEOfolgreich gebucht. Gepaart mit der super Arbeit von Timo und seinem Team ist meine Webseite innerhalb weniger Wochen auf Seite 1 der Google Suche mit meinem relevanten Keyword gerankt. Mittlerweile stehe ich seit einigen Monaten auch auf Platz 1 in der Google Suche und bei Google Maps, dadurch konnte ich viele Anfragen und auch Neukunden generieren. Ich kann allen, die sich selbstständig machen wollen, nur empfehlen von Anfang an das Thema local SEO auf dem Schirm zu haben und mit Timo Specht als Agentur zusammenzuarbeiten.“

Die frisch gelaunchte Website war zum Start schön, jedoch nicht sichtbar, genauso wenig wie Jule’s Google Business Profil.

Um schnell relevante Neukundenanfragen zu generieren fokussierten wir uns rein auf die Moneykeywords = alle Keywords mit Kaufabsicht “Texter München”.

Nach 6 Monaten Optimierung erreichten wir mit Jule die Pole Position als Nummer 1 „Texter München“ sowohl in Google organisch als auch in Google Maps. Jule bekommt jetzt täglich Neukundenanfragen.

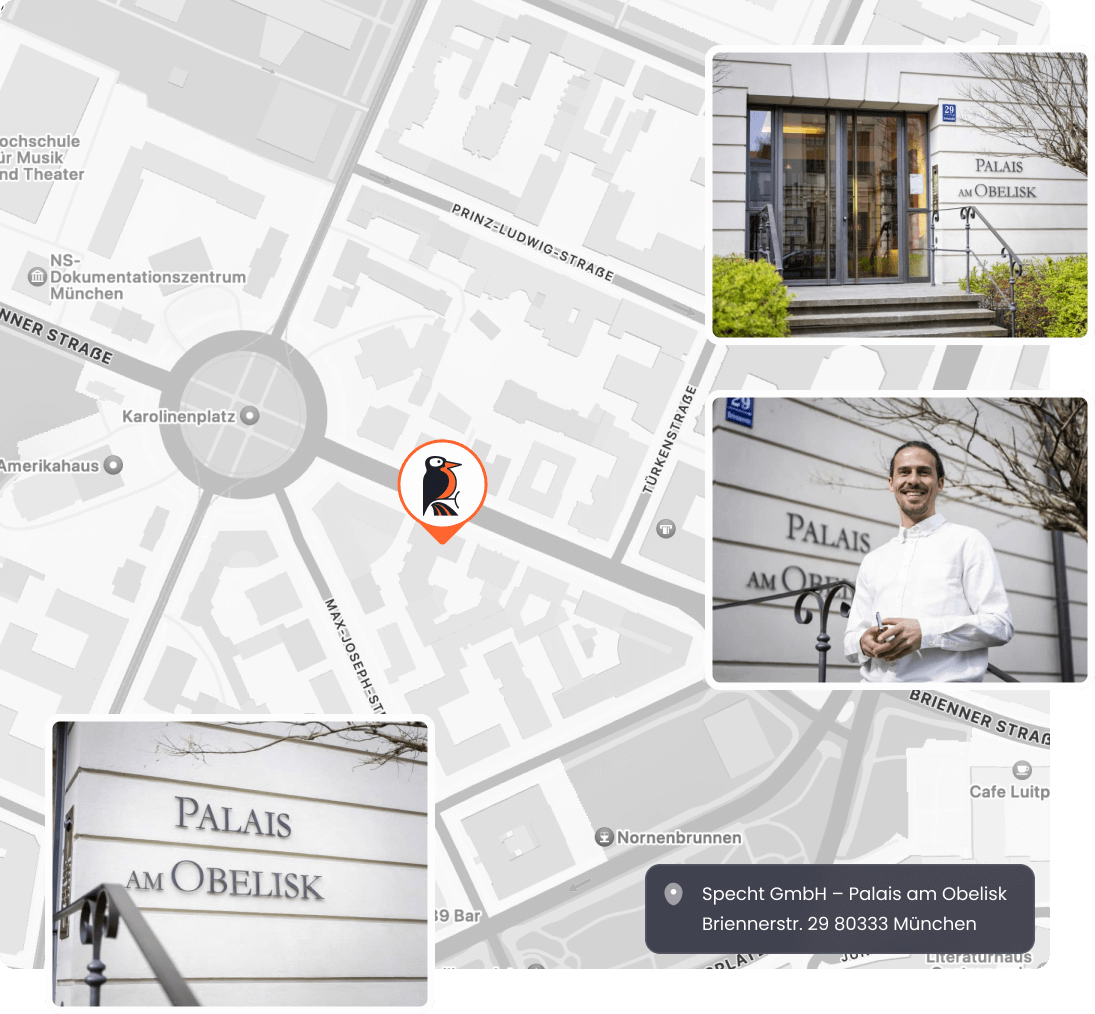

Standort

Unser Unternehmens-Standort in München

Die Brienner Straße 29, 80333 befindet sich zentral in der Altstadt und der Maxvorstadt von München.

Sie ist nach dem Ort der Schlacht von Brienne benannt und neben der Ludwigstraße, der Maximilianstraße und der Prinzregentenstraße, eine der vier städtebaulich bedeutenden Prachtstraßen der Landeshauptstadt von Bayern.

Unser SEO & Online Marketing Büro befindet sich im Palais am Obelisk.Am besten zu erreichen ist es von Osten über den Karolinenplatz, der in unmittelbarer Nachbarschaft liegt und im Westen des allseits bekannten Odeonsplatz.

Auch der Münchner Hauptbahnhof ist schnell von unserem Büro aus erreichbar.

Team

Wir haben ein exklusives SEO-Expertenteam zusammengestellt, das täglich Deine Website optimiert

Unsere SEO-Experten schrauben täglich an den wichtigsten Stellschrauben, um Deine Seite auf Google voranzubringen!

Timo Specht

Gründer & SEO Experte

Christoph Specht

Gründer & SEO Experte

Valeria

Content Expertin

Schritte

Ablauf einer erfolgreichen Zusammenarbeit mit uns!

Schritt 1:

- Kontaktformular Ausfüllen

Klicke unten auf den Button und fülle das Kontaktformular wahrheitsgemäß aus. Bitte formuliere Dein Anliegen in einem Satz, damit wir sofort wissen, um was es geht. Du wirst zum Kalender weitergeleitet, wo Du Dir einen freien Slot mit unserem Team aussuchen kannst.

Schritt 2:

- Kostenfreies Erstgespräch

Im Erstgespräch lernen wir uns kennen. Dabei finden wir heraus, in welcher Ausgangslage Du Dich befindest und welche Zielsetzung Du erreichen möchtest. Sofern wir Dir weiterhelfen können, vereinbaren wir im Anschluss ein Strategiegespräch.

Schritt 3:

- Strategiegespräch & Angebot

Im persönlichen 1:1 Strategiegespräch präsentieren wir Dir Deine individuelle SEO-Strategie und zeigen Dir die Wachstumspotentiale auf. Im Gespräch erhältst Du ein maßgeschneidertes Angebot, um Deine Zielsetzung zu erreichen.

Bewertungen

Kundenstimmen erfolgreicher SEO-Projekte

Mehr als 300+ Kunden vertrauen unserer Expertise und bewerten uns mit 5 von 5 Sternen bei Google, Trustpilot & Co. Wir sind die bestbewerteste SEO-Agentur in Deutschland.

Carlheinz Bartsch

Bartsch Immobilien GmbH

Verifizierte Trustpilot Bewertung

Kelsey Nielsen

Personio

„I worked with Timo on an SEO content audit as well as consulting him on a few SEO-related technical and logistical questions. He is a clear subject matter expert, provided a great audit with clear next steps, and was able to answer all of my questions. Highly recommend and will definitely be working with him again!“

„

Verifizierte Trustpilot Bewertung

Michael Wunderlich

Geschäftsführer – Praxis Ortho Lehel

„Vielen Dank Timo an Dich und Dein Team für die sympathische, perfekte und extrem professionelle Unterstützung

bei SEO und SEA ab dem ersten Tag, an jedem Tag. Ihr seid sofort zur Stelle wenn man Euch braucht. Meine Vorstellungen wurden bei weitem übertroffen! Absolute Weiterempfehlung von mir an jeden!

DANKE!“

Verifizierte Trustpilot Bewertung

Christian Mazilu

Shisha World

„Sehr gute Fachkompetenz. Angenehme Persönlichkeit mit sehr gutem Verständnis für E-Commerce SEO und Content. Absolut Up2Date. Sind sehr zufrieden in der Zusammenarbeit. Absolute Weiterempfehlung für Unternehmen als auch Selbständige, die nachhaltig Ihr Business voranbringen möchten.“

Verifizierte Google Bewertung

Daniel Rakus

SEA Experten GmbH & CoKG

„Top SEO Agentur – alle Ziele wurden erreicht. Nach 6 Monaten haben wir ein Top Ranking zu den ausgewählten Begriffen und auch sonst wurde die Sichtbarkeit der Webseite verbessert. Zusammenarbeit auf Augenhöhe und professionell!“

Verifizierte Google Bewertung

Carlheinz Bartsch

Bartsch Immobilien GmbH

Verifizierte Trustpilot Bewertung

Kelsey Nielsen

Personio

„I worked with Timo on an SEO content audit as well as consulting him on a few SEO-related technical and logistical questions. He is a clear subject matter expert, provided a great audit with clear next steps, and was able to answer all of my questions. Highly recommend and will definitely be working with him again!“

„

Verifizierte Trustpilot Bewertung

Michael Wunderlich

Geschäftsführer – Praxis Ortho Lehel

„Vielen Dank Timo an Dich und Dein Team für die sympathische, perfekte und extrem professionelle Unterstützung

bei SEO und SEA ab dem ersten Tag, an jedem Tag. Ihr seid sofort zur Stelle wenn man Euch braucht. Meine Vorstellungen wurden bei weitem übertroffen! Absolute Weiterempfehlung von mir an jeden!

DANKE!“

Verifizierte Trustpilot Bewertung

Christian Mazilu

Shisha World

„Sehr gute Fachkompetenz. Angenehme Persönlichkeit mit sehr gutem Verständnis für E-Commerce SEO und Content. Absolut Up2Date. Sind sehr zufrieden in der Zusammenarbeit. Absolute Weiterempfehlung für Unternehmen als auch Selbständige, die nachhaltig Ihr Business voranbringen möchten.“

Verifizierte Google Bewertung

Daniel Rakus

SEA Experten GmbH & CoKG

„Top SEO Agentur – alle Ziele wurden erreicht. Nach 6 Monaten haben wir ein Top Ranking zu den ausgewählten Begriffen und auch sonst wurde die Sichtbarkeit der Webseite verbessert. Zusammenarbeit auf Augenhöhe und professionell!“

Verifizierte Google Bewertung

Lukas Uhl

Vaillant

Verifizierte Google Bewertung

Specht GmbH: Deine SEO & SEA-Spezialisten

Sichere Dir jetzt Dein kostenloses Strategiegespräch

- #1 In deiner Nische

- Mehr Anfragen & Verkäufe

- Mehr Umsatz